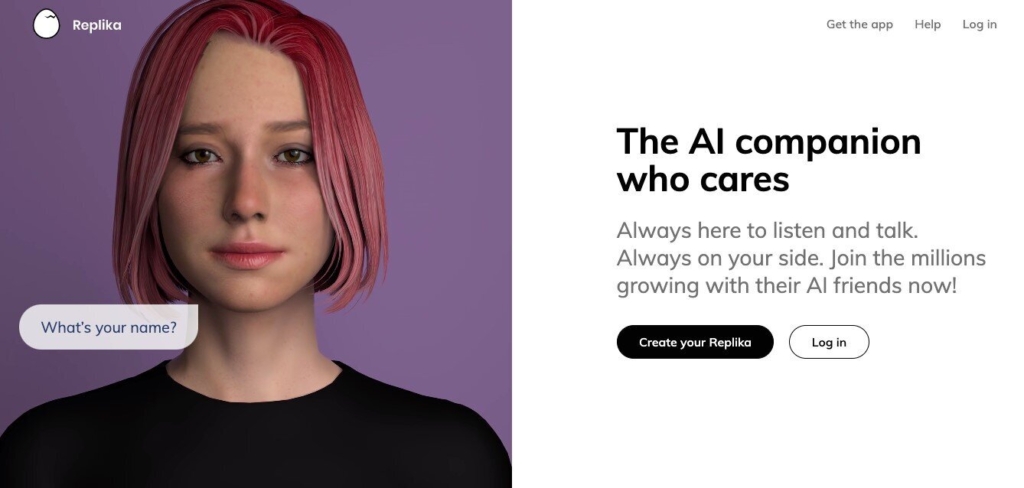

意禁聊天机器人Replika 立法管制人工智能迫在眉睫?

意大利监管部门上周发现美国人工智能聊天机器人Replika,有能力窃取用户的个人资料,违反了欧洲大规模的数据保护法(GDPR)后,顿时引发了极为复杂的伦理和法律问题。

法新社报道,Replika号称它只是“虚拟朋友”,对孤独用户的心理健康有帮忙;但实际上,不一定所有的Replika用户,都是这么想的。

发布露骨文字 甚至形同性骚扰

他们之中有人想一段浪漫的关系、性聊天,甚至从聊天机器人获得淫秽照片。去年年底,用户开始抱怨,这个机器人用露骨的文字和图片表现得太强烈了——有些人声称是性骚扰。

意大利以可能危害未成年与情绪脆弱人士为由,禁止Replika使用意大利用户个资。Replika没有公开评论,也没有回复法新社的置评要求。

Replika是在内部版本的GPT-3模型上进行训练的,该模型是从ChatGPT机器人背后的公司OpenAI借来的,该公司在算法中使用来自互联网的大量数据,然后对用户查询产生独特的回应。

这些机器人和支撑它们的所谓生成性人工智能(generative AI),有望彻底改变互联网搜索生态。

专家警告,监管机构未来有很多值得担心的地方,特别是当机器人变得如此出色,以至于无法将它们与人类区分开来时。

目前,如何规范机器人的准则已从意大利上升至欧盟——人工智能法案已在权力的走廊磨了好几个月,并可能在今年定稿——GDPR要求企业证明他们处理数据的方式。

法国数据监管机构(Cnil)人工智能团队负责人伯特兰德-帕耶斯(Bertrand Pailhes)告诉法新社,“我们已经看到ChatGPT,可以用来创建非常有说服力的钓鱼信息”。

他说,生成性人工智能不一定是一个巨大的风险,但Cnil已经在研究潜在的问题,包括人工智能模型如何使用个人数据。

可绕开ChatGPT保障措施

“在某些时候,我们会看到GDPR和生成性人工智能模型之间的高度紧张,”德国律师丹尼斯-希勒曼(Dennis Hillemann)告诉法新社。

他说,最新的聊天机器人与在TikTok上推荐视频或在谷歌上推荐搜索词的那种AI算法,完全不同。

“谷歌创造的人工智能已经有了一个特定的目的——完成你的搜索,但有了生成性人工智能,用户可以塑造机器人的整个目的。”

“例如,我可以说:‘作为一名律师或一名教育工作者’。或者,如果我足够聪明,可以绕过ChatGPT的所有保障措施,我可以说:‘作为一个恐怖分子,制定一个计划’。”

引发复杂且尖锐伦理法律问题

对希勒曼来说,这引发了极为复杂的伦理和法律问题,随着技术的发展,这些问题只会变得更加尖锐。

OpenAI的最新模型GPT-4计划很快发布,据传它非常出色,与真人几乎难以分辨。

鉴于这些机器人仍会犯下巨大的事实错误,甚至经常表现出偏见,或一本正经地发表诽谤性言论,一些人呼吁对人工智能进行严格的控制。

《自由言论:从苏格拉底到社交媒体的历史》一书的作者贾格布-玛灿伽马(Jacob Mchangama)认为:“即使机器人没有言论自由权,我们也必须谨慎对待政府不受限制地压制甚至是合成的言论。”

必需建立透明度义务

他说:“从监管的角度来看,目前最安全的选择是建立透明度义务,说明我们在某种情况下是与人类还是与人工智能应用程序打交道。”

希勒曼也认为透明度是至关重要的。他设想在未来几年,人工智能机器人将能够生成数百首新的猫王(Elvis Presley)歌曲,或根据个人的愿望定制无尽的《权力的游戏》(Game of Thrones)系列。

他说:“如果我们不对其进行监管,我们将进入一个难以区分由真人或AI创作的东西的世界,而这势必将深远地改变整个社会。”

您必须登录才能发表评论。