公开资源最多顶8年 人工智能将面临数据枯竭

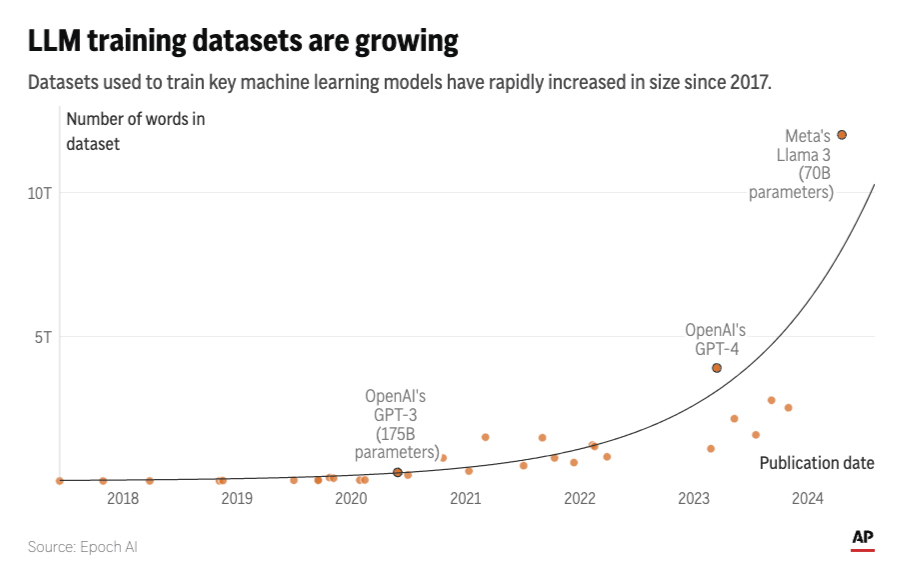

人工智能(AI)系统如ChatGPT,可能很快耗尽其变得更智能所需的资源——即人们在线撰写和分享的数万亿字词汇。根据研究机构Epoch AI最新发布的研究,科技公司可能在2026年至2032年之间,耗尽可用于训练AI语言模型的公开数据资源。

美联社报导,研究作者之一塔梅·贝西罗格鲁(Tamay Besiroglu)将此情形比作“淘金热”,他表示,当人类生成的文本资源耗尽时,AI领域将难以维持当前的进展速度。短期内,科技公司如OpenAI和谷歌正竞相获取并支付高质量的数据源,例如通过协议获取Reddit论坛和新闻媒体的内容。

然而,从长远来看,不会有足够的新博客、新闻文章和社交媒体评论来支撑AI的发展。这迫使公司不得不使用敏感的私密数据,如电子邮件或短信,或依赖于由聊天机器人生成的低可靠性“合成数据”。

AI模型扩展将变得低效

贝西罗格鲁指出:“如果数据量受限,模型扩展将变得低效,而模型扩展是提高AI系统能力和输出质量的关键。”

2年前,研究人员首次预测高质量文本数据将在2026年耗尽。尽管新技术提高了数据利用率,有时还能多次训练同一数据源,但这些方法是有限的。Epoch预计,公共文本数据将在未来2到8年内耗尽。

该团队的最新研究已通过同行评审,并计划在今年夏天于奥地利维也纳举行的国际机器学习会议上展示。Epoch是由旧金山的Rethink Priorities主办,并由有效利他主义支持者资助的非营利研究所,致力于缓解AI的最坏风险。

贝西罗格鲁提到,AI研究人员十多年前就意识到,扩展计算能力和大量互联网数据可以显著提高AI系统性能。根据Epoch的研究,输入AI模型的文本数据量每年增长2.5倍,计算能力每年增长约四倍。

然而,数据瓶颈的问题是否值得担忧,尚有争议。多伦多大学计算机工程助理教授尼古拉斯·帕佩诺(Nicolas Papernot)表示,构建更熟练的AI系统也可以通过训练专门用于特定任务的模型来实现。但他对使用AI系统生成的输出进行训练表示担忧,称这会导致“模型崩溃”。

维基媒体基金会的首席产品和技术员塞莱娜·德克尔曼(Selena Deckelmann)表示,AI公司应关注如何保持人类生成内容的存在和可访问性。尤其是在廉价和自动生成的“垃圾内容”开始污染互联网时,她希望仍有激励措施让人们继续贡献。

OpenAI首席执行员山姆·阿尔特曼(Sam Altman)在联合国的活动中表示,虽然已经尝试生成大量合成数据用于训练,但他对过度依赖合成数据持保留态度,认为这在某种程度上显得低效。

您必须登录才能发表评论。